mongodb 架构

1. 逻辑结构

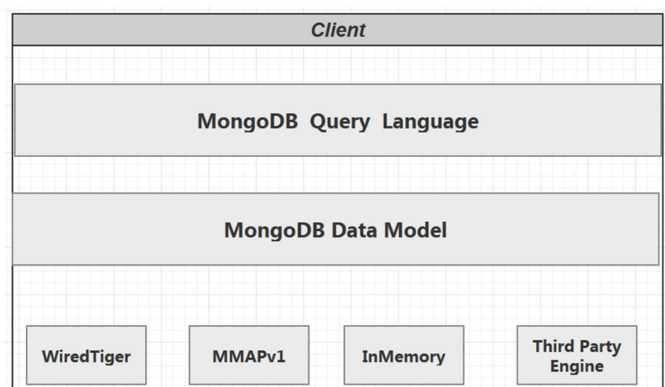

MongoDB与MySQL中的架构相差不多,底层都使用了可插拔的存储引擎以满足用户的不同需要。用户可以根据程序的数据特征选择不同的存储引擎,在最新版本的MongoDB中使用了WiredTiger作为默认的存储引擎,WiredTiger提供了不同粒度的并发控制和压缩机制,能够为不同种类的应用提供了最好的性能和存储率。

在存储引擎上层的就是MongoDB的数据模型和查询语言了,由于MongoDB对数据的存储与RDBMS 有较大的差异,所以它创建了一套不同的数据模型和查询语言。

2. 数据模型

内嵌

内嵌的方式指的是把相关联的数据保存在同一个文档结构之中。MongoDB的文档结构允许一个字段或者一个数组内的值作为一个嵌套的文档。

引用

引用方式通过存储数据引用信息来实现两个不同文档之间的关联,应用程序可以通过解析这些数据引用来访问相关数据。

如何选择

内嵌

1.数据对象之间有包含关系,一般是数据对象之间有一对多或者一对一的关系。

2.需要经常一起读取的数据。

3.有map-reduce/aggregation需求的数据放在一起,这些操作都只能操作单个collection。

引用

1.当内嵌数据会导致很多数据的重复,并且读性能的优势又不足于覆盖数据重复的弊端。

2.需要表达比较复杂的多对多关系的时候。

3.大型层次结果数据集嵌套不要太深。

3. 存储引擎

3.1 概述

存储引擎是MongoDB的核心组件,负责管理数据如何存储在硬盘和内存上。MongoDB支持的存储引擎有

- MMAPv1

- WiredTiger

- InMemory

InMemory存储引擎用于将数据只存储在内存中,只将少量的元数据(meta-data)和诊断日志(Diagnostic)存储到硬盘文件中,由于不需要Disk的IO操作,就能获取所需的数据,InMemory存储引擎大幅度降低了数据查询的延迟(Latency)。从mongodb3.2开始默认的存储引擎是WiredTiger, 3.2版本之前的默认存储引擎是MMAPv1,mongodb4.x版本不再支持MMAPv1存储引擎。

storage:

journal:

enabled: true

dbPath: /data/mongo/ #

#是否一个库一个文件夹

directoryPerDB: true

##数据引擎

engine: wiredTiger

##WT引擎配置

WiredTiger:

engineConfig:

##WT最大使用cache(根据服务器实际情况调节)

cacheSizeGB: 2

##是否将索引也按数据库名单独存储

directoryForIndexes: true

journalCompressor:none (默认snappy)

##表压缩配置

collectionConfig:

blockCompressor: zlib (默认snappy,还可选none、zlib)

##索引配置

indexConfig:

prefixCompression: true

3.2 WiredTiger优势

文档空间分配方式

WiredTiger使用的是BTree存储 ; MMAPV1 线性存储 需要Padding

并发级别

WiredTiger 文档级别锁; MMAPV1引擎使用表级锁

数据压缩

snappy (默认) 和 zlib ,相比MMAPV1(无压缩) 空间节省数倍。

内存使用

WiredTiger 可以指定内存的使用大小。

Cache使用

WT引擎使用了二阶缓存WiredTiger Cache, File System Cache来保证Disk上的数据的最终一 致性。而MMAPv1 只有journal 日志。

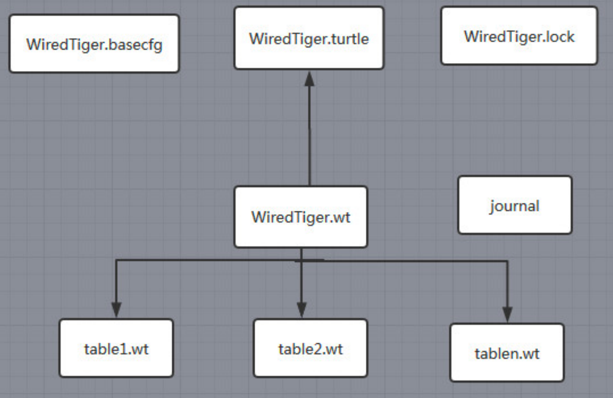

3.3 WiredTiger引擎包含的文件和作用

WiredTiger.basecfg: 存储基本配置信息,与 ConfifigServer有关系

WiredTiger.lock: 定义锁操作

table*.wt: 存储各张表的数据

WiredTiger.wt: 存储table* 的元数据

WiredTiger.turtle: 存储WiredTiger.wt的元数据

journal: 存储WAL(Write Ahead Log)

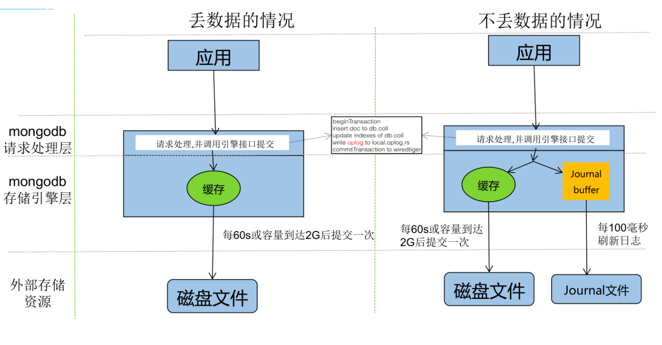

3.4 WiredTiger存储引擎实现原理

写请求

WiredTiger的写操作会默认写入 Cache ,并持久化到 WAL (Write Ahead Log),每60s或Log文件达到2G做一次 checkpoint (当然我们也可以通过在写入时传入

j: true的参数强制 journal 文件的同步 ,writeConcern: { w:, j: , wtimeout: }) 产生快照文件。WiredTiger初始化时,恢复至最新的快照状态,然后再根据WAL恢复数据,保证数据的完整性。

Cache是基于BTree的,节点是一个page,rootpage是根节点,internal page是中间索引节点,leaf page真正存储数据,数据以page为单位读写。

WiredTiger采用Copy on write的方式管理写操作(insert、update、delete),写操作会先缓存在cache里,持久化时,写操作不会在原来的leaf page 上进行,而是写入新分配的page,每次checkpoint都会产生一个新的rootpage。

checkpoint流程

1.对所有的table进行一次checkpoint,每个table的checkpoint的元数据更新至WiredTiger.wt 2.对WiredTiger.wt进行checkpoint,将该tablecheckpoint的元数据更新至临时文件WiredTiger.turtle.set 3.将WiredTiger.turtle.set重命名为WiredTiger.turtle。 4.上述过程如果中间失败,WiredTiger在下次连接初始化时,首先将数据恢复至最新的快照状态, 然后根据WAL恢复数据,以保证存储可靠性。Journaling

在数据库宕机时,为保证MongoDB中数据的持久性,MongoDB使用了Write Ahead Logging向磁盘上的journal文件预先进行写入。除了journal日志,MongoDB还使用检查点(checkpoint)来保证数据的一致性,当数据库发生宕机时,我们就需要checkpoint和journal文件协作完成数据的恢复工作。

1.在数据文件中查找上一个检查点的标识符

2.在journal文件中查找标识符对应的记录

3.重做对应记录之后的全部操作